FlowiseAI RAG sohbeti

FlowiseAI, geliştiricilerin özelleştirilmiş LLM orkestrasyon akışları ve AI ajanları oluşturmaları için düşük kodlu bir araçtır. FlowiseAI aracını Gaia düğümlerini LLM hizmet sağlayıcıları olarak kullanacak şekilde yapılandırabilirsiniz.

Ön Koşullar

Genel bir URL aracılığıyla LLM hizmetleri sağlamaya hazır bir Gaia düğümüne ihtiyacınız olacak. Yapabilirsin

Bu eğitimde, Continue eklentisine güç sağlamak için genel düğümleri kullanacağız.

| Model tipi | API temel URL'si | Model adı |

|---|---|---|

| Sohbet | https://llama8b.gaia.domains/v1 | lama |

| Yerleştirme | https://llama8b.gaia.domains/v1 | nomik |

Bir FlowiseAI sunucusu başlatın

Flowise 'ı yerel olarak kurmak için FlowiseAI kılavuzunu izleyin

npm install -g flowise

npx flowise başlangıcı

Başarıyla çalıştırdıktan sonra, Flowise AI aracını kontrol etmek için http://localhost:3000 adresini açabilirsiniz.

Belgeleri sorgulayan bir sohbet robotu oluşturun

FlowiseAI, bir yapay zeka aracısı için tüm iş akışı bileşenlerini görsel olarak ayarlamanıza olanak tanır. FlowiseAI'de yeniyseniz, hızlı başlangıç için bir şablon kullanmanız önerilir. Aslında, Flowise pazarında OpenAI ile ilgili çok sayıda şablon var. Tek yapmamız gereken ChatOpenAI bileşenini ChatLocalAI bileşeni ile değiştirmek.

Örnek olarak Flowise Docs QnA' yı ele alalım. Belgelerinize dayalı bir QnA sohbet robotu oluşturabilirsiniz. Bu örnekte, bir GitHub deposundaki bir dizi belge ile sohbet etmek istiyoruz. Varsayılan şablon OpenAI ile oluşturuldu ve şimdi bunu bir Gaia düğümünde açık kaynaklı bir LLM kullanmak için değiştireceğiz.

Flowise Docs Soru-Cevapşablonunu edinin

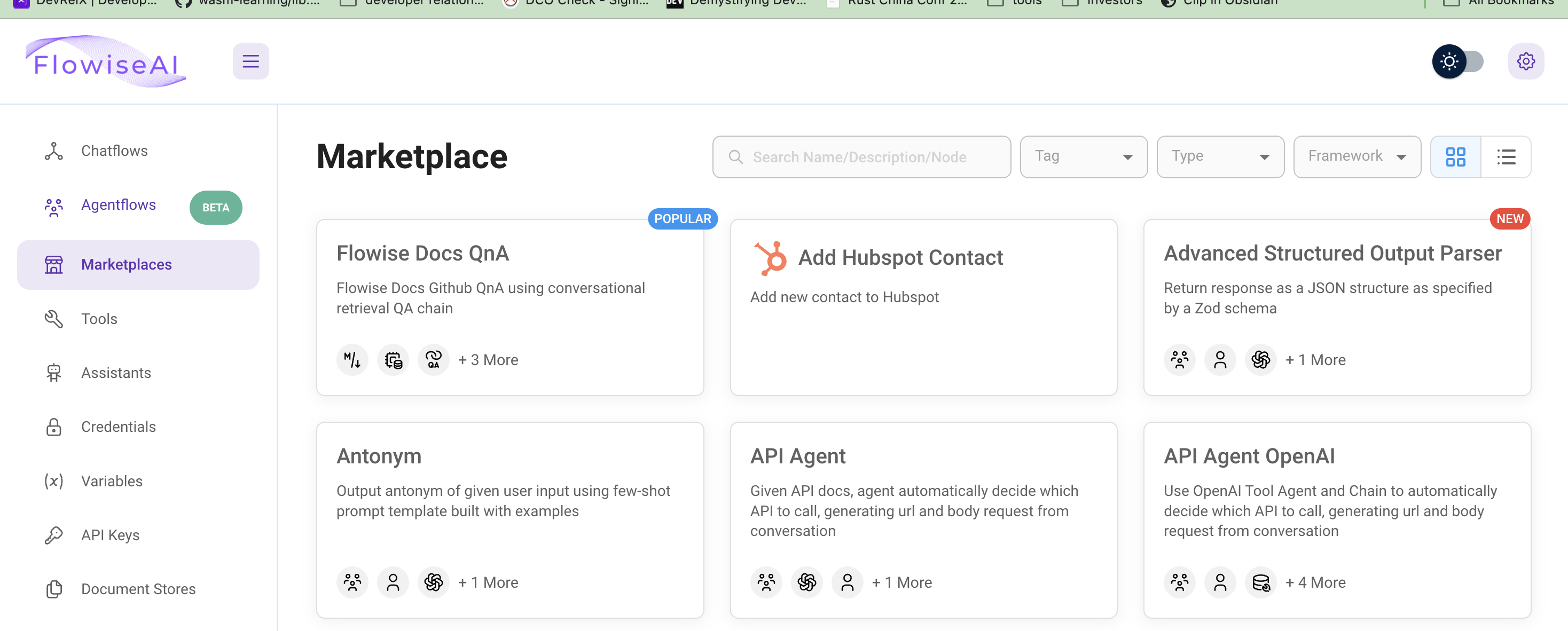

Tüm şablonlara göz atmak için sol sekmedeki Marketplaces'a tıklayın. Kullanacağımız şablon Flowise Docs QnA ilk şablon.

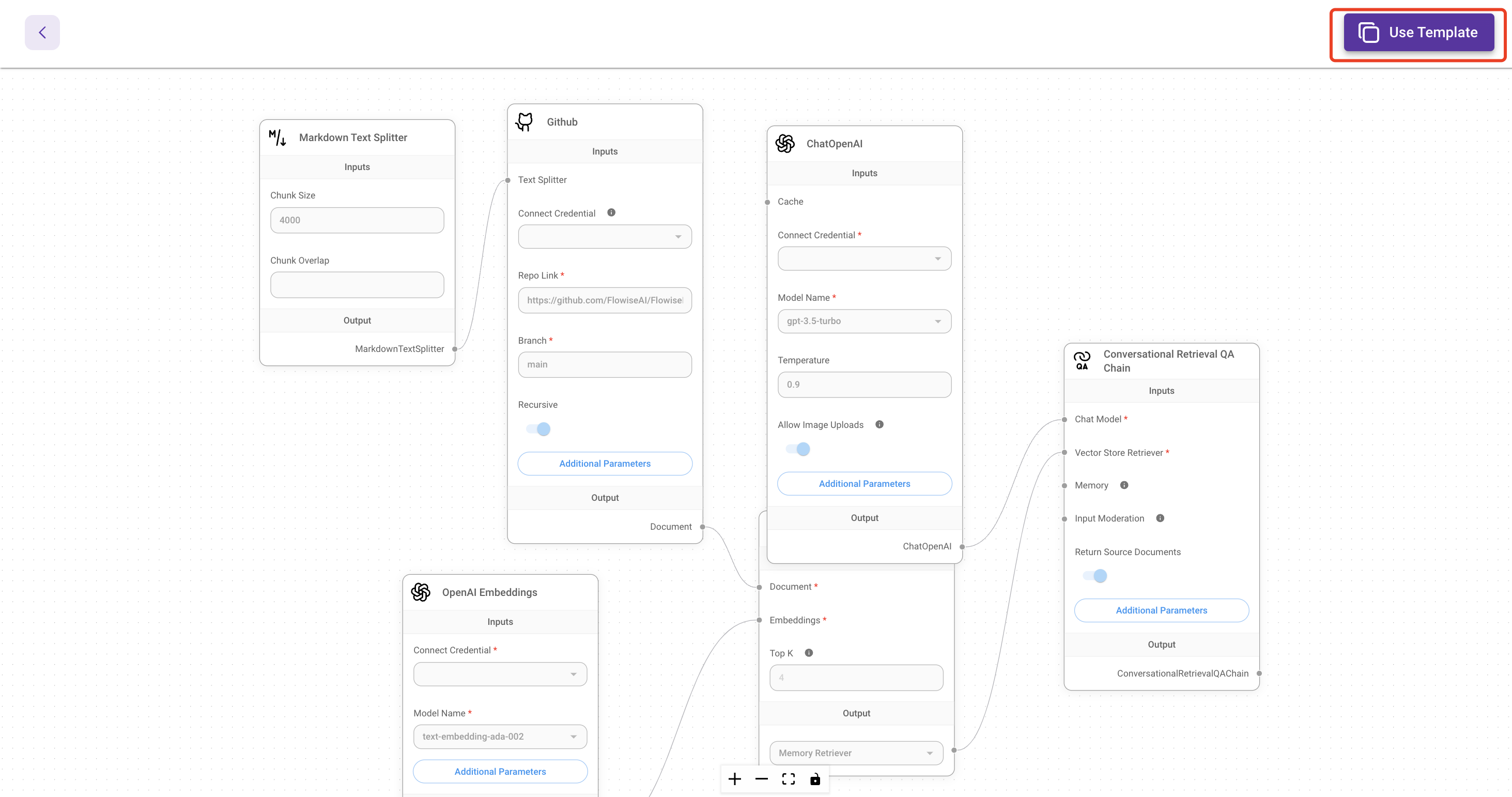

Ardından, görsel düzenleyiciyi açmak için sol üst köşedeki Bu şablonu kullan düğmesine tıklayın.

Sohbet modeli API'sini bağlayın

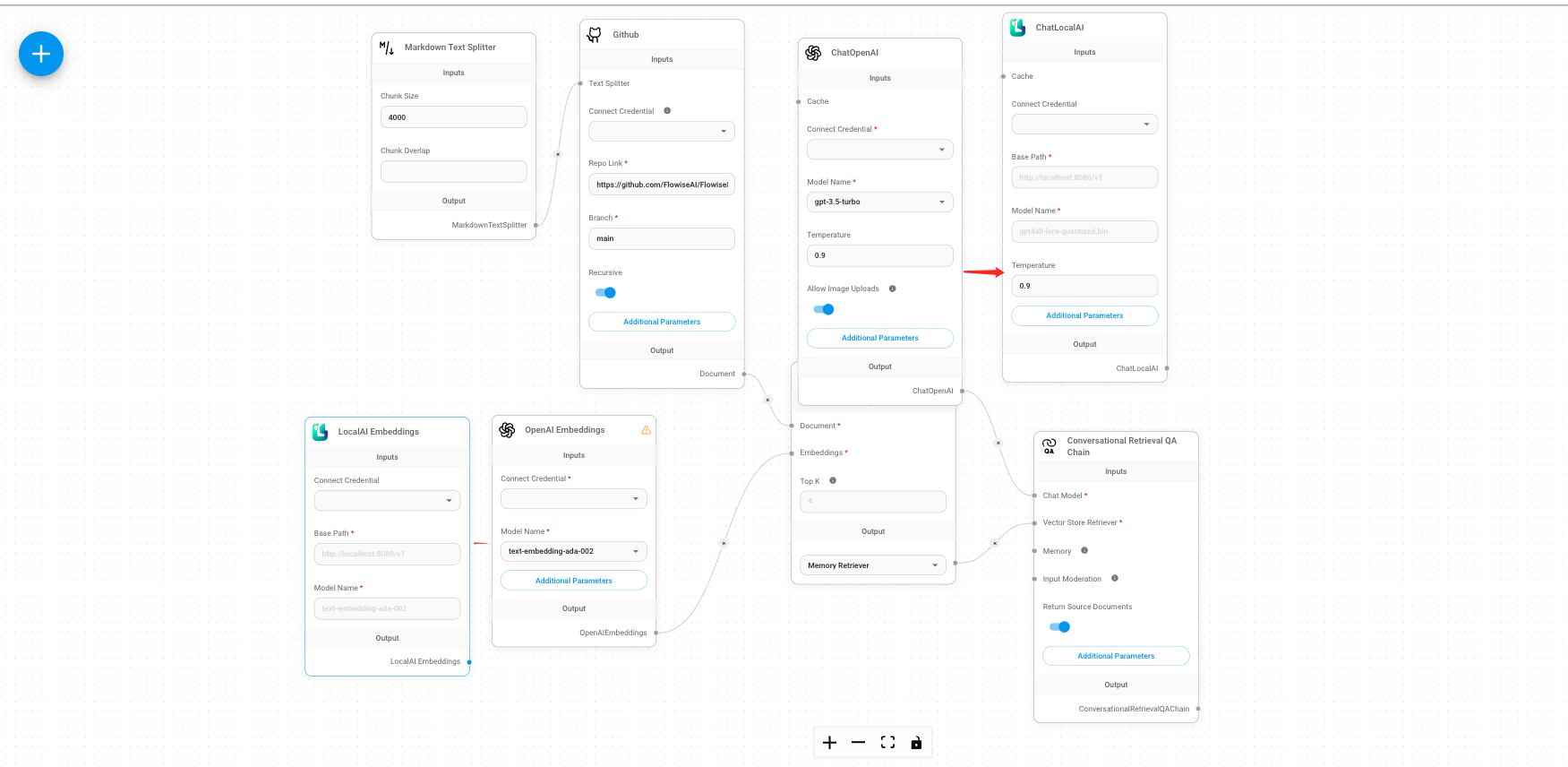

ChatOpenAI bileşenini silmeniz ve ChatLocalAI'yi aramak için + düğmesine tıklamanız ve ardından ChatLocalAI'yi ekrana sürüklemeniz gerekecektir.

Ardından, şunları girmeniz gerekecektir

- Gaia düğüm tabanı URL'si

https://llama8b.gaia.domains/v1 - model adı

lama

Ardından, ChatLocalAI bileşenini şu alana bağlayın Sohbet modeli içinde Diyaloğa Dayalı Geri Alma QA Zinciri bileşen.

Yerleştirme modeli API'sini bağlayın

Varsayılan şablon, belgeleriniz için katıştırmalar oluşturmak için OpenAI Embeddings bileşenini kullanır. OpenAI Embeddings bileşenini LocalAI Embeddings bileşeni ile değiştirmemiz gerekiyor.

- Gaia düğüm tabanı URL'sini kullanın

https://llama8b.gaia.domains/v1Temel Yol alanına girin. - Model adını girin

nomic-embed-text-v1.5.f16Model Adı alanına girin.

Sonra, bağlayın Yerel Yapay Zeka Yerleştirmeleri alanı ile bileşen gömme içinde Bellek İçi Vektör Deposu bileşen.

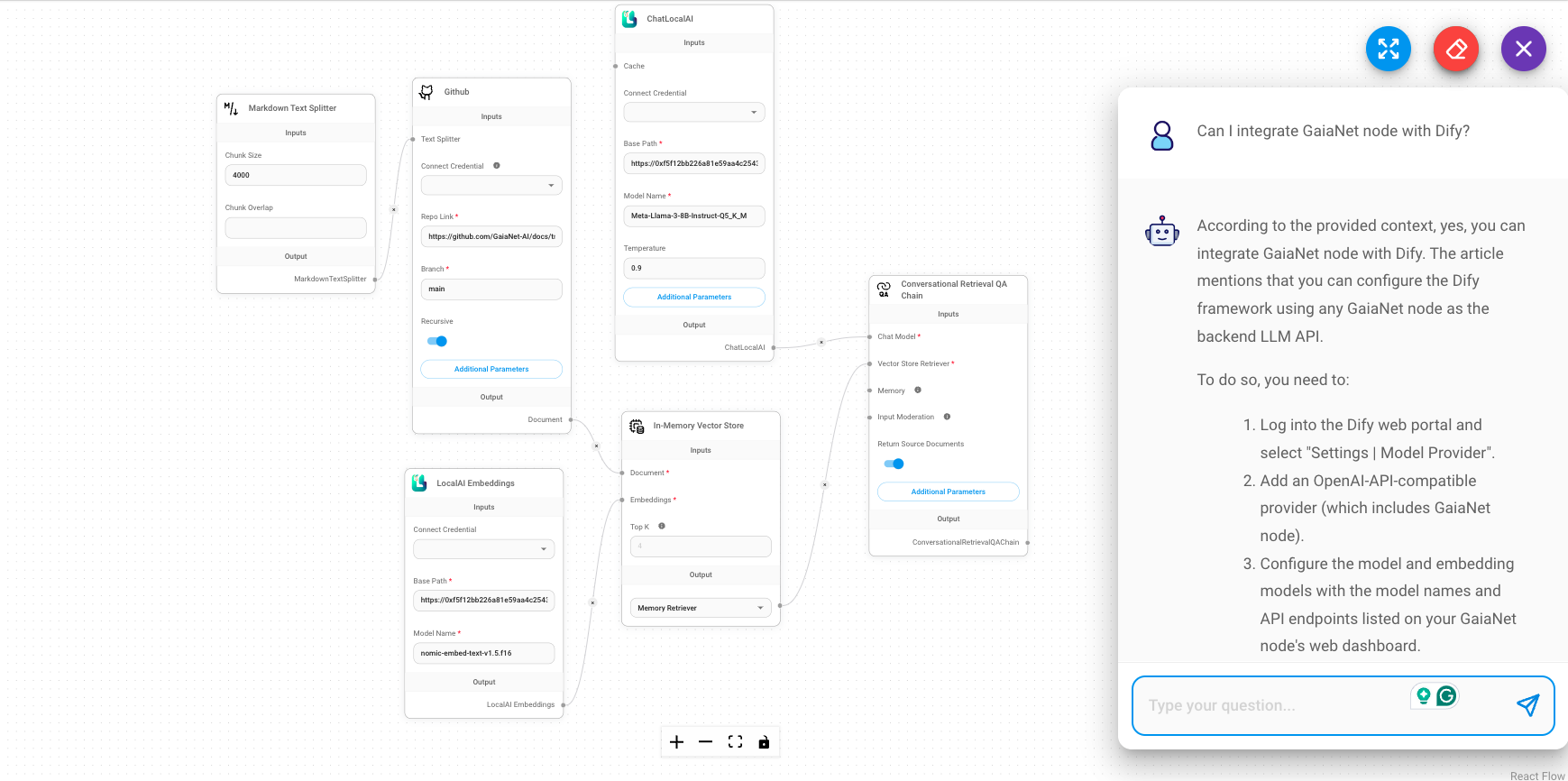

Belgelerinizi ayarlayın

Ardından, sohbet uygulamasını GitHub'daki belgelerimize bağlamak için GitHub bileşenini inceleyelim. Dokümanlarınızın GitHub bağlantısını Repo Bağlantısı alan. Örneğin, Gaia'nın dokümanlar bağlantısını koyabilirsiniz: https://github.com/GaiaNet-AI/docs/tree/main/docs.

Bir deneyin

Mevcut sohbet akışını kaydettikten sonra "Gaia düğümü nasıl kurulur" gibi bir soru gönderebilirsiniz.

Cevabı, daha doğru olan Gaia dokümanlarına dayanarak alacaksınız.

Daha fazla örnek

Flowise pazarında çok sayıda örnek var. Gaia tabanlı bir Flowise aracısı oluşturmak için, Chat OpenAI ve OpenAI Embeddings bileşenini Gaia temel URL'si ile değiştirmeniz yeterlidir.